换脸App背后的恐慌:我的脸什么时候会被伪造,又该如何辨别?

谁能想到,全民换脸的时刻这么快就来临了。在一夜之间,朋友圈几乎被ZAO刷屏,亲朋好友们纷纷用自己的脸换上了电影明星的脸,“上演天下好戏”。

这种以假乱真的换脸视频技术,其实已经不是什么新鲜事了。但一直以来,它还只是名人们的“烦恼”,例如担心自己成为色情片的主角。而如今ZAO的火爆却证明,换脸对常人的吸引力到底有多大。上热搜,登顶应用商店,一度被挤爆服务器,这款简单的换脸APP获得了惊人的流量。

然而在火爆之后,质疑声也接踵而至。很多人开始针对ZAO的用户协议提出批评,直指你的脸有可能被恶意利用,甚至在出现侵权问题时也可能是你来背锅。

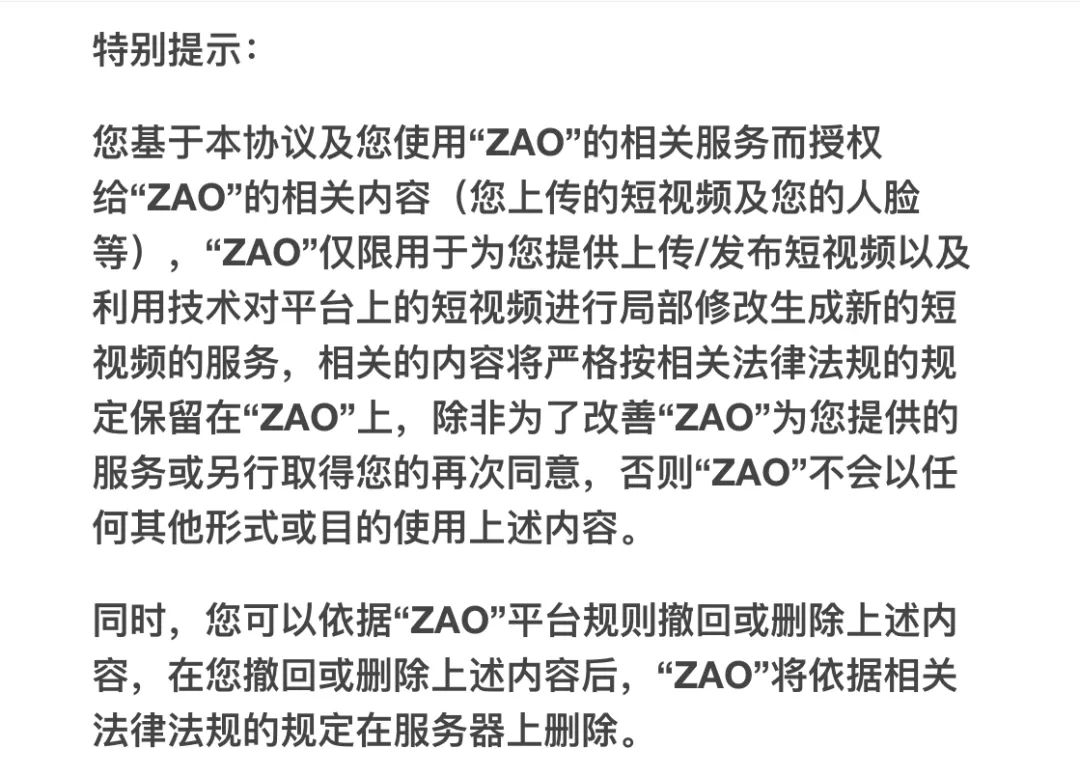

在受到争议后,ZAO修改的最新用户协议 | ZAO用户协议截图

让AI技术触及大众本来是件好事,那换脸视频到底出了什么问题呢?

换脸变得越来越容易

要了解这种换脸视频是如何实现的,Deepfake技术是绕不开的话题。

2017年,一位叫做“Deepfakes”的Reddit网友上传了几个色情视频,引起轰动。令人意外的是,这些视频里的演员都是名人,比如“神奇女侠”盖尔·加朵和“赫敏”艾玛·沃森。当然这些视频并不是真的,而是借由AI技术伪造,这种技术因此得名Deepfake。

“我只是找到了一个聪明的方法来换脸。”Deepfakes在接受Vice采访时说, “有了数百张面部图像,我就能轻松生成数百万变形的图像来训练神经网络。然后,当我向网络输入某人的脸部图像时,网络只会认为这是另一张变形图像,从而尝试让它看起来像是训练时所用的脸。”

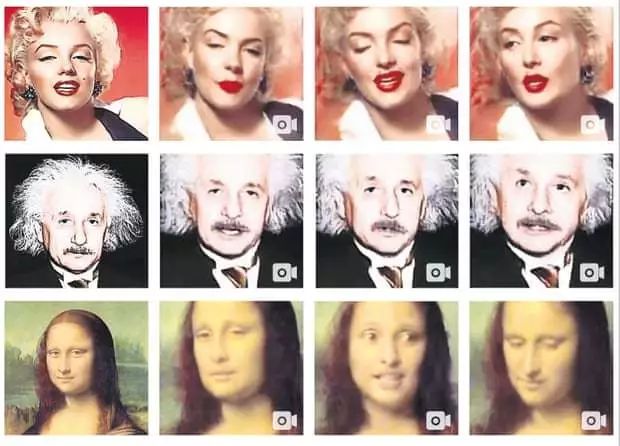

动起来的玛丽莲梦露、爱因斯坦和蒙娜丽莎 | Egor Zakharov/YouTube

这就是被称为“生成对抗网络”(GAN)的一种深度学习技术。简单来说,要伪造视频,我们首先需要两个神经网络来参与。网络A会生成一个假的视频片段,然后问网络B这个视频是否为真,网络B的反馈能够加强网络A所生成图像的可信度。前者被称作生成网络,后者则为判别网络。

就这样,两个神经网络在不断对抗中学习,直至Deepfake生成以假乱真的视频。

★

2017年12月

Reddit网友“Deepfakes”在社区r / deepfakes发布伪造的名人色情视频,其中包括演员斯嘉丽·约翰逊、歌手泰勒·斯威夫特和凯蒂·佩里等人。Deepfakes声称自己所使用的是多个深度学习的开源库,例如Google 的人工智能框架TensorFlow。

2018年1月

能够换脸的软件FakeApp推出,该软件同样基于TensorFlow开发。

2018年2月

Reddit禁止用户在r / deepfakes分享深度学习伪造的非自愿色情内容,Twitter和成人视频网站Pornhub也在随后做出类似举动。

2018年9月

Google在禁止列表里添加了“非自愿合成色情图像”,允许任何人请求搜索引擎封锁有关自己的虚假色情内容。

2018年12月

斯嘉丽·约翰逊在《华盛顿邮报》公开谈论Deepfake事件:“任何人都会成为目标,这只是时间问题”。

2019年2月

26日,一段杨幂的换脸视频蹿红网络。名为“换脸哥”的B站Up主通过Deepfake修改了94版《射雕英雄传》的视频片段,将朱茵的脸换成杨幂的脸。2月27日,“换脸哥”发布微博称“及时下架了相关视频”,并指出“大家应尊重版权与肖像权,专注于技术本身”。

2019年6月

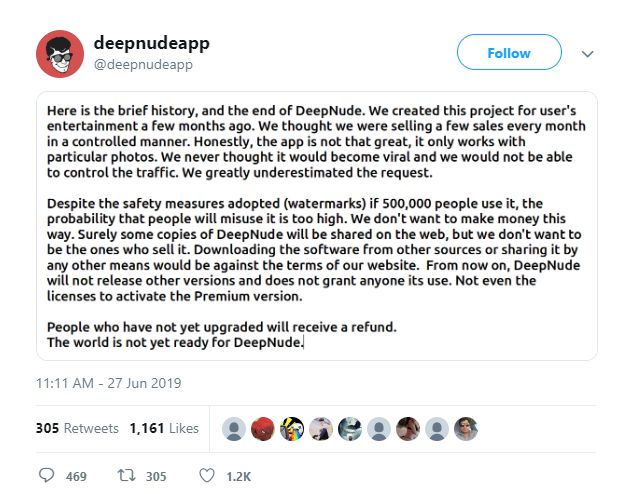

DeepNude的Windows和Linux程序公开下载,该程序能够将图像中女性的衣物删除。6月27日,DeepNude的开发者关闭该程序。

不只是隐私问题

如今,Deepfake让“眼见不一定为实”有了新的诠释。“无图无真相”的时代早已过去,换脸、换头甚至换声音的技术让真相变得更加扑朔迷离。

在国外媒体BuzzFeed通过FakeApp制作的一段视频中,你可以看到电影制作人乔丹·皮尔(Jordan Peele)充当奥巴马所发表的讲话。

BuzzFeed视频片段 | BuzzFeedNews

“这是一个危险的时代。我们在互联网所相信的东西,我们对此应该更加警惕。”皮尔假扮的“奥巴马”说。

值得注意的是,像Deepfake和FakeApp这样的技术和程序已经有很多了。由德国研究人员开发的Face2Face,能实时捕捉人的面部图像,并将其移植到另一个视频中。人的神态和动作也能被轻易模仿,通过斯坦福大学的研究人员开发的“深度视频肖像”( Deep Video Portraits)技术,你能像操控牵线木偶一般生成假视频——实现转头、做出表情、注视和眨眼等动作。

与此同时,声音也能被伪造了。早在2016年,Adobe就展示了自己的Voco软件(至今仍未发布),该软件只需要20分钟的目标语音,就能生成听起来十分相似的语音。创业公司Lyrebird的产品声称,只用一分钟的音频就能模仿任何人说话。而百度推出的Deep Voice算法,甚至将生成假音频所需的音频时间减少到3.7秒。

DeepNude官方推特的声明 | deepnudeapp/Twitter

在这些技术的加持下,轻易就能伪造却难以辨伪的内容,可能让社会面临种种威胁,而色情视频只是其中一个缩影。评论者们指出,任何人都将无法保护自己的隐私权和肖像权,假新闻更容易猖獗,政客甚至可以用其攻击竞争对手,别有用心的人可能借此影响股市等。个人信息的安全也更难保证,合成的语音或视频将欺骗生物验证,例如需要真人才能验证的语音和面部识别。

但更令人担忧的问题在于,FakeApp和ZAO这样的AI程序正在变得唾手可得。更多人能够接触到这类AI技术,意味着其被滥用的可能性也相应增加了。

如何揭露真相?

面对Deepfake的泛滥,一个很自然的解决方法是,技术引发的问题交给技术来解决。

从技术上来说,Deepfake会在篡改视频上留下可预测的伪造痕迹,而深度学习算法能够检测到它们。这些算法是公开的,也有像罗切斯特理工学院的马特·怀特(Matt Wright)这样的研究者,正在尝试搭建能够探测假视频的网站,用户可以在时间轴上看到视频可能被篡改的位置。而对于Facebook这样的大平台来说,他们也会用自己开发的算法来过滤假视频。

美国国防部高级研究计划局(DARPA)已经专门成立“媒体取证”项目(The Media Forensics)来解决Deepfake带来的问题,并资助研究者探索自动检测Deepfake的最佳方法。其中一个受到资助的研究团队发现,可以通过分析视频中的眨眼来辨别Deepfake,因为名人眨眼的照片并不多。

视频片段,盖尔·加朵的脸被放在了色情电影演员的身上 | vice.com

在推进假音频检测的过程中,Google在2019年的ASVspoof挑战中为开发人员提供了合成语音的数据集,帮其开发更安全的自动语音验证系统。除此之外,甚至还有更为硬核的研究:检测Deepfake音频的不再是AI本身,而是小鼠。

在最近的一项研究中,俄勒冈大学的研究人员成功训练老鼠来检测假的语音。通过让小鼠辨别辅音,例如不同语境中“buh”和“guh”的区别,小鼠能够以80%的准确度辨别真假语音。研究人员表示,用小鼠模型来研究复杂声音处理是很有前景的,“研究哺乳动物的听觉系统检测音频的计算机制,有助于研究下一代的欺骗检测通用算法”。

除技术之外,我们还有办法应对Deepfake的横行吗?目前的Deepfake还无法做到非常逼真,因此有些细微瑕疵还是能够通过肉眼识别。为此,Buzzfeed总结了一些辨别方法:

1.不要妄下结论;

2.考虑内容的来源;

3.验证这些内容都出现在哪些地方;

4.检查人物的嘴部动作;

5.放慢视频,仔细观察。

然而在这个“后真相”的时代,我们很难奢求所有人都花心思去辨别一个视频的真伪。而在全民“ZAO”脸的狂欢下,已经轻易将自己的肖像拱手相让的我们,会有心思去辨别什么是真,什么是假吗?

作者:EON

编辑:八云

一个AI

AI不坏,但要看你怎么用。

本文来自果壳,未经授权不得转载.

如有需要请联系sns@guokr.com

欢迎转发到朋友圈~

对于在一夜之间刷爆朋友圈的ZAO,你怎么看?有玩过的朋友吗?

扫描下面的二维码,授权进入果壳粉丝VIP社群吧!

AI和同事们等你来玩哦~