人类做不到的事,帝王蟹靠吃就能解决丨好消息合集

大型吃草帝王蟹拯救珊瑚礁

受气候变化、污染、疾病、过渡捕捞等影响,世界各地的珊瑚礁都面临严重退化。那些珊瑚虫曾经生活的区域,现在被大量海草所占据。

佛罗里达国际大学的马克·巴特勒(Mark Bulter)及其研究团队发现,有种鲜为人知的加勒比帝王蟹(Maguimithrax spinosissimus)对珊瑚礁的生态有着重大的影响——它们能协助消灭海草,恢复珊瑚。

图 | Dr. Paddy Ryan

这种蟹能吃下数量惊人的海草,而且速度不亚于任何加勒比地区的鱼类或无脊椎动物。连其他动物避之不及的海草,它们也来者不拒。

进一步的实验表明,在放养了这种螃蟹的区域,一年后海草的覆盖面积从85%下降到了50%以下,而对照组则没有明显变化;如果先人工清除部分海草,再放养螃蟹的话,则能消灭约80%的海草。没有引入螃蟹的情况下,人工清除海草只能在短期起效。

永远不要小瞧吃货的力量。

AI无人机自动评估海岸鲨鱼风险

在南加州,曾经难得一见的大白鲨,如今开始频繁出现在靠近岸边的温暖水域中,给周边的海滩带来了不小安全隐患。

为此,加利福尼亚大学圣巴巴拉分校的海洋科学教授与圣地亚哥州立大学的计算机科学家一起,开发了名为SharkEye(意为“鲨鱼之眼”)的新项目,以便更好地监测沿岸水域,并研究鲨鱼的迁徙情况。

SharkEye正在寻求追踪一只南加州海岸附近的大白鲨 | Benioff Ocean Initiative, University of California Santa BarbaraCredit

在该项目中,无人机按照既定的飞行轨迹,在约37米的高度向下俯视,巡查预定海域。飞手则从实时视频中识别出在该区域活动的鲨鱼,并形成文字信息群发给指定的救生员、冲浪教练以及海岸边的居民等,以提前发出预警。无人机拍摄的影像资料还将被输入电脑,用于训练AI自动识别大白鲨。

此外,这些数据还将和海水温度、海洋动物迁徙情况等数据一起纳入机器学习模型,在未来,人工智能有望提前预测鲨鱼出现的时间和地点,自动评估海滩鲨鱼风险,让人与鲨鱼更好地分享这片海域。

海岸如此舒适,愿人与鲨鱼和平共处。

便携式太阳能设备给医疗器械消毒

为了给医疗设备彻底消毒,通常要用到高压蒸汽。但对于许多条件不发达的地区来说,生产消毒所需的饱和蒸汽(温度>121°C,压力>205kPa)是件很难的事。虽然也可以利用太阳能,但往往还得配上昂贵而笨重的光学部件才行。

麻省理工学院的科学家们日前开发出了一种新型太阳能装置,无需复杂的聚光器就能有效生产饱和蒸汽,十分便携实用。

测试中的新型太阳能装置 | MIT News

该装置的核心是一层经过优化的超透明二氧化硅气凝胶,它能高效地将热量集中起来,提高局部的热通量和温度,以更高的效率将水加热到高压釜所需的温度和压力。

经测试,该装置只需在阳光下暴晒约10分钟,就能产生100°C的蒸汽;在现实环境中,其能效可达47%,几乎达到以往同类设备的两倍。

如果这种低成本的太阳能高压灭菌器能大规模投入使用,或许可以大大减轻偏远地区医疗系统的负担,特别是在疫情期间。同时,这种新型的太阳能吸收和转化技术,也有望促生太阳能在发电、工业生产以及能量转换、存储与运输方面的新应用。

即便不是疫情期间,日常能用上的话相信也能帮到更多人!

不用眼睛就能“看到”形状

目前,全球有4000多万人遭受着失明之苦。多年以来,科学家一直在寻找能使盲人恢复视力的神经植入物。以往的技术主要是将植入物放置在视网膜上,刺激视神经产生信号,从而让患者“看”到图像。然而对于视神经受损的患者来说,这种办法是行不通的。

近期,荷兰神经科学研究所的科学家利用新技术,开发出由1024个电极组成的高分辨率新型植入物。这些电极阵列能将图像信号转换成电刺激,绕过眼睛和视神经,直接刺激大脑视觉皮层,与大脑接口,使大脑“看”到图像。这是目前脑部植入物能取得的最高分辨率。

图 | pixabay

这项技术首先在猴子身上完成了验证。研究人员传输的人工像素图像,几乎立刻就被猴子识别出了形状、动作或字母,也就是猴子不用眼睛就“看到”了这些图像。

在未来,这种技术可以用于恢复因视网膜、眼睛或视神经问题造成失明,但视觉皮层仍然完好的人的视力,显著提高他们的自理能力和生活质量。

愿所有人都有光明的未来。

拍张照就知道吃下了多少卡路里

计算自己吃下了多少卡路里,是人们用来控制体重的常见方法之一。

然而,准确估算食物中含有多少热量是相当困难的。每次看着顾中一老师微博上发的那一团小肉丁,都感觉自己就在濒临饿死的边缘(并不是)。更别提出去下馆子时,那些复杂的菜肴,精致的甜点,怎么可能算清卡路里嘛!

好消息是,德国卡尔斯鲁厄理工学院的科学家用神经网络模型,制作了一个人工智能程序,只需要拍张照片,它就能相对准确地计算出照片中的食物大约含有多少卡路里,甚至无需手动输入食材分量和配料等信息。

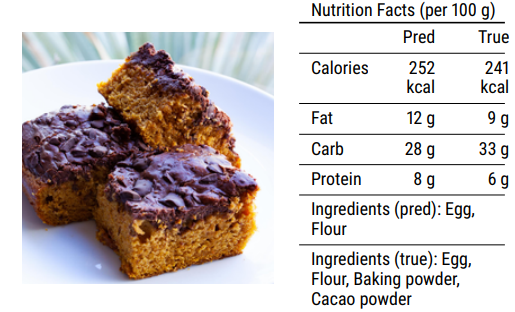

程序识别出的巧克力蛋糕的营养成分表 | 参考文献5

科学家通过互联网收集了约7万个食谱(包括食材成分及说明)和与其对应的大约30.8万张图片,并将食材的营养信息与现有的营养学数据库进行了匹配。

接下来,科学家利用多任务机器学习和卷积神经网络(convolutional neural networks)技术,让AI学习将照片和现有的食谱匹配起来,并估算各种食材的量,最后通过查询营养学数据库,将结果汇总成营养成分表,显示给用户。

为了鼓励大家进一步研究,科学家甚至还公开了生成数据集和模型的代码。

我缺的是计算热量吗,我缺的是毅力(哭。

为听障人士实时生成手语视频

对于听障人士来说,手语是相当常见的沟通方式。但网络上的视频大多没有配手语,视频通讯对他们来说也极为不易。

近期,英国萨里大学的本·桑德斯(Ben Saunders)和同事使用神经网络技术,制造了一个能将口语转换为手语图片或形成实时视频的AI程序“SignGAN”。

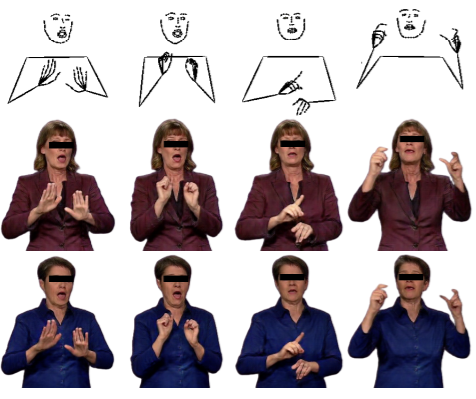

过去此类程序只能生成简陋的图形头像,或是抽象的火柴人动作,传达的内容难以为听障人士所理解。

在这次的研究中,科学家们采用了一个带有混合密度网络(MDN)的AI模型,将口语转换成“火柴人”形状的身体骨架姿势。接着,他们再以真人照片作为模板,利用生成式对抗网络(GAN)的机器学习AI,将身体骨架姿势合成为逼真的手语照片,或是连贯的动作视频。

逼真的手语视频生成示例,比火柴人好懂多了~ | 参考文献6

这一研究将大大有助于听障人士和其他人之间的交流,增加听障人士在使用语音、视频沟通方面的便利。

视频通话的时候如果能用上这个就太方便了!

本期的好消息到此就告一段落了~那么,哪个是你最pick的好消息呢?你最近又看到了哪些想跟大家分享的好消息?

参考文献

作者:欧剃

编辑:八云

本文来自果壳,未经授权不得转载.

如有需要请联系sns@guokr.com