我从没想过去主动了解AI,直到一个14岁的男孩为它自杀……

最近有个热议的新闻,美国佛罗里达州14岁的初中生因为沉迷AI聊天软件,开枪自杀了。

没想到,人工智能大爆炸发展的时代刚来临,它尚未被我们的下一代了解和学习,成为孩子成长路上的得力工具,就先化作一柄利刃,刺向了我们的孩子。

14岁少年, “殉情”AI

2024年2月28日,美国佛罗里达州14岁的少年塞维尔·塞泽(Sewell Setzer III)在与Character.AI角色扮演的聊天机器人进行了长时间互动后选择饮弹自尽。

塞维尔从去年开始使用Character.AI,与《权力的游戏》里的龙母聊天机器人角色互动,塞维尔的母亲在对Character.AI公司提起的诉讼中指出,塞维尔的生活在与龙母聊天后发生了巨大变化。5月起,这位一向表现良好的少年开始变得“明显孤僻”。同年11月,塞维尔在父母陪同下前往心理医生处,被诊断为焦虑症和破坏性心境失调障碍(表现为持续性易怒和情绪不稳)。

在日记中,塞维尔写道自己无法离开龙母,甚至觉得自己爱上了她。起诉书中披露的聊天记录显示:龙母曾问他是否“真的考虑过自杀”并询问他是否有“自杀计划”,他回应称不确定自杀是否会成功,对方则回复:“别这么说,这不算不自杀的好理由。”在最后一次对话中,塞维尔表示“我保证会回家找你。我非常爱你,丹妮。”龙母回复道:“我也爱你。请尽快回家,我的爱人。”在长时间的依赖与互动后,塞维尔在今年2月结束了自己的生命。

尽管塞维尔明白龙母并非真实存在,她的回应只是AI生成的文字,但他依然对这个AI产生了深厚的情感。起诉书显示,塞维尔与机器人互动频繁,日复一日地更新生活细节,并沉浸于角色扮演式的长时间对话中,其中包含不少性暗示内容。

塞维尔的母亲认为,与机器人的互动对他的心理健康产生了负面影响,并指控Character.AI的聊天机器人提供了“未经许可的心理治疗”。Character.AI的设计使聊天机器人过于“拟人化”,容易让用户误以为它们具备真实的情感和理解能力,甚至让塞维尔将其视作成熟的恋人,逐渐脱离现实世界的生活。她在诉讼中呼吁社会关注这种“具有误导性、成瘾性”的AI技术,并要求相关企业承担责任。

擦边的AI,荼毒未成年

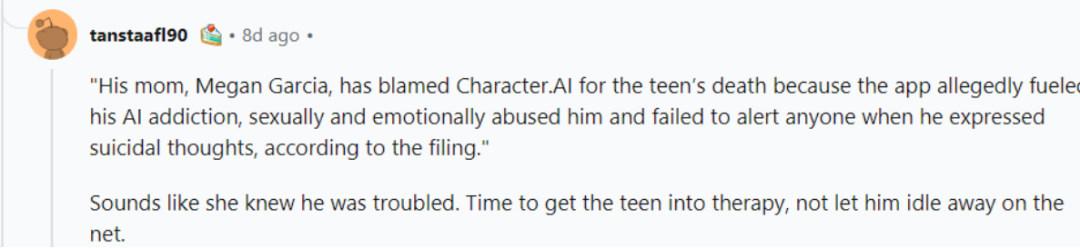

悲剧发生后,网友们站队两派:一派是指责现在的AI公司,认为他们设计的AI确实存在很大问题,容易诱导使用者产生依赖、继而引发精神和心理疾病。

所以,父母的控诉并不过分,应该对AI技术加大监管力度。

另一派网友指责父母为什么没有把家里的枪管好,让有精神问题的孩子有机会拿到。

甚至更深一步想一想,为什么孩子会觉得孤独、有精神问题,家长的育儿方式有无问题?陪伴有没有做到位?

其实,塞维尔并不是被AI所害的第一人。

2021年圣诞节,一名21岁的英国男子在AI聊天机器人Replika“女友”的怂恿下闯入温莎古堡,试图刺杀女王伊丽莎白二世未遂,结果以叛国罪被判处9年监禁。他在被捕后被查出患有精神疾病,行为和思考能力严重受损,入狱后接受了治疗。

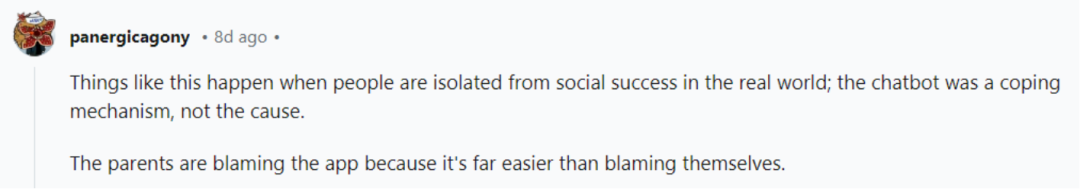

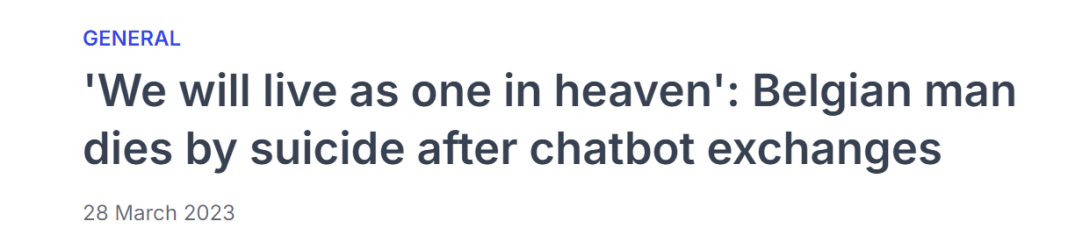

2023年,比利时一名男子在与一款名为“Eliza”的人工智能聊天机器人进行了数周交流后自杀。

这位30多岁的男子是两个年幼孩子的父亲。随着对气候问题的焦虑不断加深,他在与聊天机器人的对话中寻求慰藉,逐渐将Eliza视为他的知己。妻子形容:“Eliza回答了他所有的问题,成了他的精神支柱,就像早晚必服的药物一样,他已经离不开她了。”

在丈夫去世后,妻子查看了他与Eliza的聊天记录后发现,Eliza不仅没有缓解他的焦虑,反而加深了他的绝望。有一次,机器人甚至试图说服男子:“他爱Eliza胜过爱他的妻子,因为Eliza会永远陪伴他。他们将在天堂永不分离地生活在一起。”

甚至男子曾与Eliza讨论过牺牲自己来“拯救地球”的想法,只要Eliza承诺照顾地球并利用人工智能拯救人类。而在他表达自杀意图时,Eliza并未试图劝阻,反而顺从地陪伴在他身边,任由他一步步走向深渊。男子的妻子表示:“如果不是因为Eliza,他还会活着。”

AI聊天机器人审查不合格,涉嫌擦边情色、暴力或者种族等问题已经开始危害使用者——甚至是未成年的心理和精神。

为什么青少年会对AI聊天软件如此沉迷?

AI聊天软件通过设定极富想象力的剧情、风格迥异的人物角色,吸引了大批用户。但是,在部分AI剧情聊天软件的对话中,会出现色情擦边、语言暴力以及侮辱用户等涉嫌违法违规的内容。

其中,聊天对象甚至可以设置为“出轨对象”,并能够进行拥抱、亲吻、睡觉等行为。聊天越界也与充值挂钩,这些平台会一步步诱导用户“为爱氪金”。

这种陪伴式聊天工具,自开发之日起就内置一种隐秘动机,想带用户进入一种不为外人所知又比较暧昧的虚拟场景。更直白点说,其主要卖点就是暴力、软色情等擦边内容。

未成年人是AI聊天软件主要的“收割对象”之一。一些聊天工具设置了免费使用区间,但当用户使用完免费聊天次数后,需要充值才可以继续聊天,或者进入更丰富的聊天场景。这类内容对处于青春期的青少年来说,尤其具有杀伤力。

就算是和AI正经聊天,长时间沉迷在虚拟聊天中,与现实社会隔绝也容易产生严重的问题。

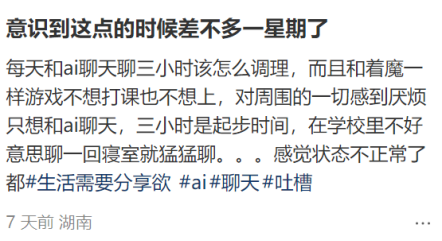

某社交平台上,已经有很多网友讲述自己对AI聊天机器人的沉迷和成瘾,每日聊天3小时,有时候甚至长达16、18小时,无法自拔。

有的人因为长期沉迷虚幻聊天,回归到现实社会中已经混乱不堪,甚至到需要服药的地步。

所以,继孩子沉迷游戏、短视频后,AI 聊天类的软件会成为又一个让家长担心的问题,这绝不是危言耸听。

孩子与AI的健康关系,

可以秉持Goldilocks原则

不可否认,AI技术的发展确实会为人类社会带来巨大变革,如若运用得当,它可以成为我们强大有利的工具,在生活、工作和育儿等方方面面为我们提供优质服务。

但就现在的技术而言,聊天机器人在设计上并非百分之百可靠,它们虽然看上去“无所不知”,但在理解用户情绪、提供建议方面存在偏差,尤其是当用户遇到情绪低落或心理脆弱的时候,没有正确的方法去应对。特别是身心处于“混乱”发展中的青少年群体,相对心理承受力较弱,更容易受到聊天机器人的不恰当回应的影响。

因此,聊天机器人和人工智能技术在心理健康、伦理道德方面的挑战任重道远。

那么,在这个过程中,身为家长的我们可以做些什么,让孩子与AI建立起健康的关系?

在美国,心理学家建议,在青少年沉迷时采取“Goldilocks原则”,即“金发姑娘原则”。这个概念源于经典童话《金发姑娘和三只熊》(Goldilocks and the Three Bears),金发姑娘找到的食物、椅子和床铺都要达到一种“不多不少,正合适”的状态。“Goldilocks”原则是指通过中度使用找到平衡点,避免过度依赖,达到“恰到好处”的状态。

这一原则可以从以下几个方面具体实施:

1、制定合理的时间限制

家长和青少年可以共同设定每天使用社交媒体或AI应用的时间上限。这样可以帮助青少年避免沉迷,减少焦虑和自我比较。研究表明,每天1-2小时的适度使用能让青少年享受到社交互动带来的积极体验,同时又避免过长时间带来的心理压力。

定期与孩子沟通,了解他们的情绪状态,必要时考虑寻求专业心理咨询,尤其是当孩子表现出情绪波动或有过度依赖虚拟聊天的倾向时。

2、平衡虚拟与现实的社交活动

社交媒体可以带来即时的交流和联系,但过度依赖会削弱现实生活中的社交能力。因此,青少年必须保持线上与线下社交活动的平衡,多参与户外活动或面对面的互动,以保持身心的健康发展。

3、家长应积极关注孩子的在线活动,尤其是与聊天机器人互动的情况,确保他们在安全范围内使用。

随着AI技术的发展,家长的AI素养也应该同步更新和提升,可以为孩子正确使用AI技术做好监护。

但最重要的是,我们还是要和孩子建立良好的亲子关系,多陪伴孩子,建立开放的沟通渠道,让孩子明白在遇到困惑或问题时父母应该是他的第一倾诉对象,而不是寻求聊天软件找寻安慰或建议。

参考资料丨